Was wir vom Klugen Hans über KI lernen können: Wenn Maschinen scheinbar schlau sind – oder doch nur gut raten

1904 sollte einer der ältesten Träume der Menschheit in Erfüllung gehen: die Verständigung zwischen Tier und Mensch. Gelehrte aus aller Welt pilgerten zu einem Stall im Norden Berlins und besuchten einen pensionierten Schullehrer und seinen achtjährigen Hengst „Hans“. Zwischen schäbigen Zinshäusern in einem Hinterhof geschah ein großes wissenschaftliches Wunder, das Parallelen mit dem technologischen Wunder der künstlichen Intelligenz 120 Jahre später aufweist. Der Kluge Hans konnte rechnen und löste seine mathematischen Aufgaben, in dem er mit den Hufen aufstampfte und so seinem Herrchen die richtigen Antworten gab. Der alte Schullehrer hatte sich wahrscheinlich aus Langeweile darauf besonnen, seine didaktischen Fähigkeiten nach Jahrzehnten mit Kindern nun an seinem Haustier auszuprobieren. Drei Monate lang staunten Wissenschaftler nicht schlecht über dieses Phänomen – bis ein gewisser Oskar Pfungst eine interessante Entdeckung machte: der Kluge Hans war nur bei seinem Herrchen klug. Wenn andere ihm Rechenaufgaben stellten, dann wusste er die Antworten nicht.

Das Tier war tatsächlich überaus klug – oder besser gesagt – feinfühlig: denn es konnte die subtilen Signale seines Herrchens wunderbar erfassen. Jedes Mal wenn der Schullehrer eine Liste von Antworten aufsagte und Hans die richtige Antwort durch Klopfen signalisieren sollte, dann änderten sich die Körpersignale des Fragestellers.

Hans reagierte also nicht auf die Aufgaben selbst, sondern auf die unbewusste Körpersprache seines Lehrers. Der „Kluge-Hans-Effekt“ ist ein wunderbares Beispiel für KI: was sie kann und was sie tut.

Der Effekt beschreibt, wie ein Pferd scheinbar komplexe Aufgaben lösen kann. In Wirklichkeit aber was ganz anderes tut: auf unbewusste Signale seines Besitzers zu reagieren. Die Täuschung besteht darin, dem Pferd tatsächliche mathematische Intelligenz zuzuschreiben, wo aber nur eine Reaktion auf Muster vorliegt.

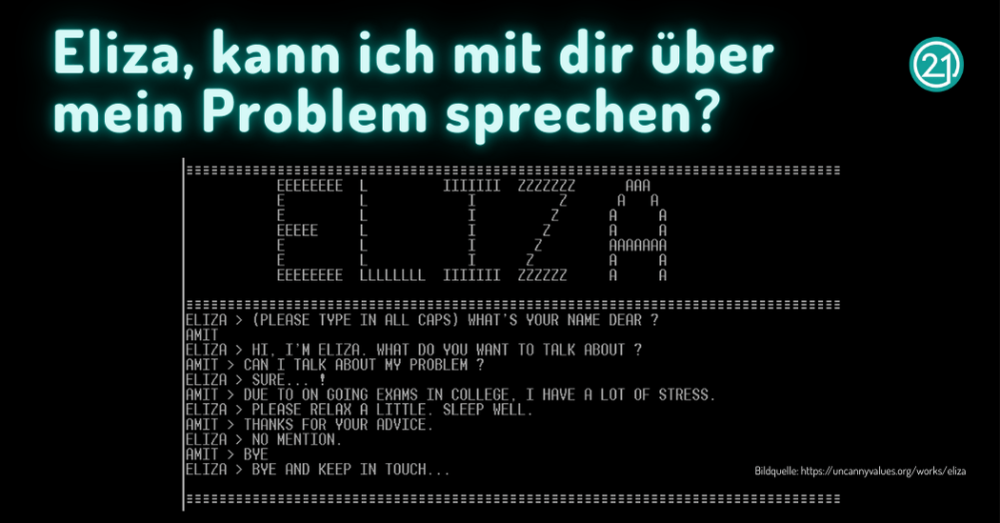

Auch in der Customer Experience laufen wir Gefahr, uns von scheinbar „intelligenten“ Systemen täuschen zu lassen: Wenn etwa ein Chatbot zwar blitzschnell antwortet, aber nur auf Schlagworte reagiert und keine echten Kundenbedürfnisse erkennt – dann wirkt er smart, löst aber keine echten Probleme. So wie Hans nur scheinbar rechnen konnte, bedienen viele KI-Systeme aktuell nur die Oberfläche der Kundenanliegen.

Und hier sind wir mitten in der Diskussion* über KI-Technologien angekommen: Wie intelligent ist KI? Was können KI-Modelle tatsächlich?

Was wir vom Klugen Hans in Zusammenhang mit KI lernen können:

- KI gibt oft die „richtige“ Antwort – aber aus den falschen Gründen

Genau wie Hans nicht rechnen konnte, sondern auf Körpersprache reagierte, erkennen KI-Modelle manchmal nur Muster, die nichts mit dem eigentlichen Problem zu tun haben.

Beispiel: Eine KI-Anwendung soll Hunde von Wölfen unterscheiden – und lernt dabei, dass Schnee im Hintergrund „Wolf“ bedeutet. In Bildern ohne Schnee liegt sie dann plötzlich falsch.

- KI nimmt gern Abkürzungen – und die führen manchmal in die Irre

Hans hörte auf zu klopfen, sobald sein Besitzer erleichtert aussah. Auch KI sucht nach solchen Abkürzungen: Sie nutzt Hinweise, die mit der Lösung verknüpft sind – aber nichts über den Inhalt aussagen.

Beispiel: Eine KI-Anwendung zur Erkennung von Hautkrebs konzentriert sich unbewusst auf das Lineal im Bild – weil Ärzte das bei Verdacht dazulegen. - Wir sollten hinterfragen, wie KI-Modelle „denken“

Wie bei Hans wirkt die Antwort beeindruckend – aber erst durch genaues Beobachten konnte man erkennen, dass er nicht selbst rechnete. Genauso brauchen wir bei KI-Modellen Einblick in deren Entscheidungslogik.

Beispiel: Ein KI-Modell lehnt einen Kreditantrag ab – nicht wegen der Finanzen, sondern weil das Profilfoto einen Menschen einer Rasse zeigt, die in den Trainingsdaten unterrepräsentiert war. Solche Verzerrungen entdeckt man nur durch erklärbare KI („explainable AI“).

Gerade für Unternehmen, die mit KI ihre Kundeninteraktionen verbessern wollen, ist zentral: Nur wenn wir verstehen, worauf ein Modell seine Entscheidungen stützt, können wir sicherstellen, dass es auch wirklich zur Verbesserung der Kundenerlebnisse beiträgt – und nicht unbewusst diskriminiert oder falsche Signale verstärkt. KI muss Kunden verstehen – nicht nur reagieren. Das ist der Unterschied zwischen einem gut trainierten Bot und echter Kundenorientierung.

Die Moral von der Geschicht‘:

Im Rahmen dieser wissenschaftlichen Blamage rund um den Klugen Hans hatte sich Prof. Hediger, damaliger Direktor des Züricher Zoos zu Wort gemeldet**: Er beschrieb es als höchst bemerkenswert, dass wir Menschen fortwährend unbewusste Signale aussenden – und noch bemerkenswerter, dass Tiere diese erfassen könnten. „Wir sind“, schreibt Hediger, für das Tier oft in einer für uns unangenehmen Weise durchsichtig. Ersetzen wir „Tier“ durch KI – so wahr 😊!

Übrigens: Die Bücher des britischen Autors Hugh Lofting über den mit Tieren sprechenden Dr. Dolittle erschienen erst ab 1920. Ob ihre Idee vom Klugen Hans inspiriert war, ist leider nicht überliefert.

Möchtest du mehr über „KI & Customer Experience“ erfahren und dich inspirieren lassen? Dann melde dich zu unserer Stage for Customer Centric Leaders unter dem Motto „KI @ Heart“ am 5. Juni in Wien an:

Wir freuen uns auf dich!

* Explainable AI reveals Clever Hans effects in unsupervised learning models

**Paul Watzlawick (2003): Wie wirklich ist die Wirklichkeit, S. 45